Prochaine évolution de l’intelligence artificielle : bien plus que des modèles

Byline : Augusto Marietti (chef de la direction et cofondateur, Kong), YJ Lu (directeur, Croissance audacieuse RREO) et Yiran Wu (analyste en placements, Croissance audacieuse RREO)

Aperçu :

Croissance audacieuse RREO et Augusto Marietti, chef de la direction et cofondateur de Kong et auteur invité spécial, examinent comment le protocole de contexte de modèle (PCM) émerge en tant que changement d’infrastructure pour des renseignements évolutifs et interopérables.

L’IA passe de modèles autonomes à des systèmes agentiques et contextuels qui peuvent établir des objectifs et exécuter des tâches de façon autonome en se connectant à des données, à des outils et à des actions réels par l’intermédiaire du protocole de contexte de modèle (PCM).

À titre de norme sectorielle gouvernée de façon neutre, le PCM devient une infrastructure essentielle pour les flux de travail agentiques, ce qui permet un changement d’écosystème semblable aux API.

Tout est une question de contexte

Dans les dernières années, l’intelligence artificielle (IA) a évolué à un rythme sans précédent. Nous avons assisté au passage des systèmes d’apprentissage automatique traditionnels aux modèles d’IA générative capables d’écrire, de coder et de raisonner avec une aisance quasi humaine. Ce changement a complètement transformé notre façon d’interagir avec l’IA, mais son évolution ne s’arrête pas là.

Nous entrons maintenant dans une nouvelle ère d’IA contextuelle et agentique, capable d’établir des objectifs et d’exécuter des tâches de façon autonome avec une intervention humaine minimale. À la base de cette transformation se trouve le protocole de contexte de modèle (PCM), ou Model Context Protocol (MCP) en anglais, une nouvelle norme qui permet de relier rapidement les modèles d’IA générative basés sur des requêtes (prompts) aux données, aux outils et aux actions du monde réel.

Épisode précédent : contexte introuvable (404)

Jusqu’à tout récemment, la plupart des grands modèles de langage de pointe (GML) fonctionnaient en « jardin clos ». Ils pouvaient recevoir et interpréter les requêtes des utilisateurs et générer du texte, mais ils n’avaient aucun moyen direct ou normalisé d’accéder à des données personnelles ni aux données, aux outils internes et aux interfaces de programmation d’applications (API) propres à une entreprise, ni à toute autre source qui aurait pu leur fournir le contexte ou les renseignements nécessaires pour proposer des réponses mieux documentées.

Pour recevoir des réponses contextuelles, les entreprises devaient auparavant concevoir des intégrations personnalisées (codes de liaison ponctuels) qui étaient souvent fragiles, coûteuses et difficiles à maintenir. Puis, en novembre 2024, Anthropic a introduit PCM en infrastructure libre. Ce protocole visait à aider les modèles de pointe à générer des réponses plus pertinentes en intégrant le contexte dans les GML sur la base d’un protocole commun. Ce protocole normalise la manière dont les modèles d’IA découvrent, appellent et authentifient les API provenant de systèmes externes, remplaçant ainsi les intégrations fragiles par une architecture commune.

PCM est rapidement devenu une norme du secteur, adoptée par de nombreux acteurs de premier plan, comme OpenAI et Google, et intégrée à leurs piles d’IA. À mesure que l’écosystème évoluera, les systèmes d’IA seront en mesure de conserver le contexte lorsqu’ils passeront d’un outil à l’autre grâce à une architecture durable.

D’accord… mais comment ça fonctionne?

Avant PCM, chaque GML avait son propre format de plugiciel et avait besoin d’un code de liaison personnalisé pour communiquer avec chaque outil. Cela a fait exploser la complexité, fragmentant l’écosystème en multiples intégrations N × M. PCM fusionne cette matrice en un système indépendant des fournisseurs en définissant des rôles clairs (hôtes, client et serveur) de sorte que les outils puissent être découverts et appelés de manière cohérente et répétitive. La création d’un serveur PCM par source de contexte permettra aux assistants IA et aux agents conversationnels hôtes conformes aux normes PCM de s’en servir comme d’un outil dans une boîte à outils.

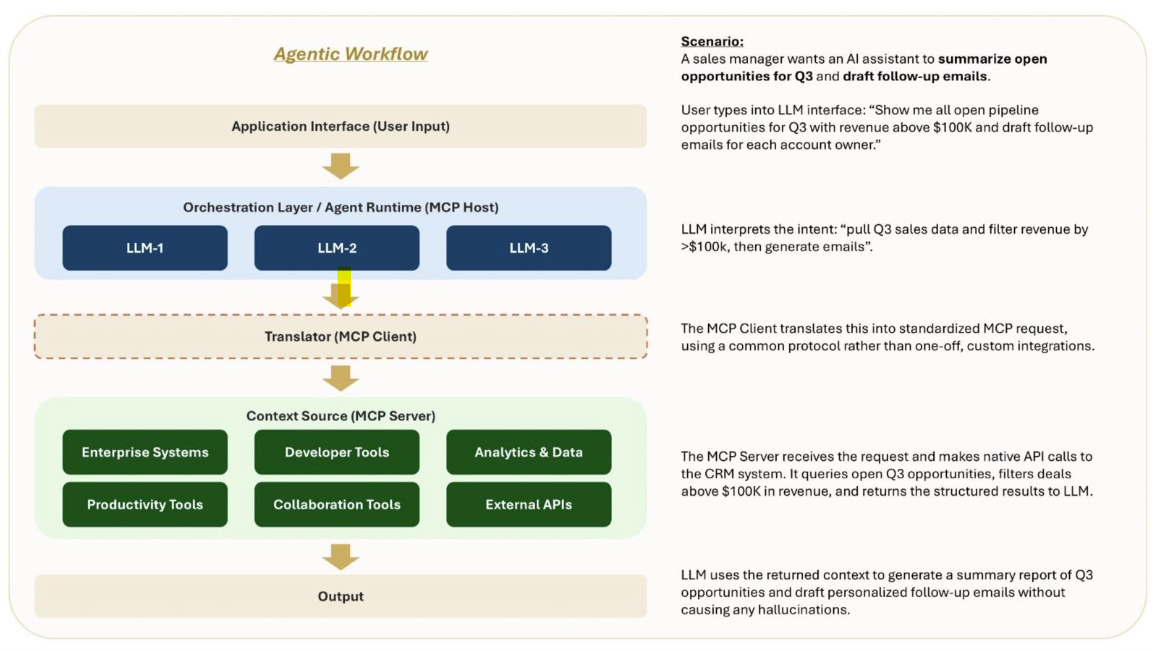

Le diagramme ci-dessous illustre cette explication. Un utilisateur saisit une requête. Le modèle interprète son intention et, point crucial, au lieu de deviner, il se réfère au contexte réel pour obtenir des précisions. Le client PCM fait office de traducteur, convertissant l’intention de l’utilisateur en demandes PCM normalisées. Les serveurs PCM s’occupent ensuite de l’exécution réelle : ils permettent un accès sécurisé et contrôlable à des sources contextuelles comme les logiciels de GRC, les outils d’analyse, les plateformes de développement et les applications de productivité, et effectuent les appels d’API sous-jacents au nom du modèle. Ces systèmes produisent des résultats structurés que les modèles utilisent pour générer des sorties utiles et contextualisées plutôt que des paragraphes de contenu plus ou moins plausible. Plus important encore, nul besoin de multiples intégrations N × M pour y arriver!

Dans les traces des API, mais avec des visées plus ambitieuses

Ce n’est pas la première fois que la technologie a besoin d’une norme commune pour être déployée à grande échelle. Auparavant, les logiciels devaient utiliser un langage commun pour connecter les systèmes. Les API étaient les « contrats » qui permettaient à un logiciel de communiquer avec un autre, définissant ce qui peut être demandé, ce qui est retourné et comment échanger ces renseignements de façon sécurisée.

Au début, les API étaient principalement des outils internes utilisés par les ingénieurs pour connecter différents systèmes au sein d’une entreprise. Au début des années 2000, des entreprises (Amazon, eBay, Salesforce, etc.) ont commencé à ouvrir leurs API à des partenaires d’affaires et à des développeurs tiers. Au fil du temps, les API sont devenues le fondement de la façon dont les applications modernes sont construites, alimentant tout, des systèmes de paiement à l’infrastructure infonuagique en passant par les connexions aux médias sociaux et à votre application météo préférée.

Toutefois, les API n’ont vraiment connu leur essor que lorsqu’elles sont devenues simples et normalisées (avec REST, JSON, OAuth et Open). Les développeurs disposaient désormais d’un moyen simple, transférable et prévisible de développer un logiciel en plus d’autres services. Grâce aux API, des entreprises entières comme Stripe, Twilio et Plaid ont pu se monétiser et exister pratiquement sous cette forme. PCM est sur le point d’emprunter le même chemin que celui de l’IA en normalisant la façon dont les modèles accèdent aux outils et aux données. À mesure que l’adoption de PCM croîtra, nous verrons probablement apparaître des éléments similaires à ceux dont les API avaient besoin autrefois : registres, outils d’observabilité, systèmes d’approbation, moteurs de politique et outils optimisés.

Notre pronostic : contexte + API + flux de travail = IA agentique

Nous faisons deux paris importants sur l’avenir des infrastructures d’intelligence artificielle. Le protocole de contexte de modèle d’Anthropic s’impose comme protocole normalisé du secteur pour relier les GML aux bons outils et aux bonnes données et permettre aux agents de communiquer en anglais clair dans diverses API, jetant ainsi les bases des flux de travail agentiques et, à terme, des systèmes agent à agent (A2A). Kong (voir ci-dessous) étend son leadership en gestion des API à la connectivité IA, servant de lien entre les systèmes d’entreprise et la nouvelle génération d’agents d’IA.

Anthropic

Anthropic a introduit PCM comme architecture libre, reconnaissant que l’avenir de l’IA ne dépend pas seulement de la construction de modèles de plus en plus grands, mais aussi de leur connexion au bon contexte. En mai 2025, Anthropic a annoncé le lancement d’Intégrations, une fonctionnalité permettant d’élargir la prise en charge de PCM au-delà des serveurs locaux de Claude Desktop en l’intégrant directement dans l’API de Claude. Cette mise à jour permet à Claude de se connecter de manière transparente à tout serveur PCM distant sans code, ce qui lui permet de découvrir des outils, d’exécuter des appels, de gérer l’authentification et de retourner des résultats intégrés. Par la suite, la feuille de route d’Anthropic évoluera, passant de la création d’agents autonomes capables d’agir vers l’orchestration de systèmes multi-agents (A2A). En pratique, il pourrait s’agir d’un agent qui extrait les données des clients, d’un autre qui effectue une analyse du portefeuille et d’un troisième qui génère un rapport prêt pour la conformité, le tout coordonné de façon transparente via PCM et A2A. Cette évolution transforme l’IA d’un seul assistant en un réseau d’agents spécialisés, ouvrant ainsi la voie à des cas d’utilisation opérationnelle de bout en bout de plus grande valeur.

Kong

Kong étend sa plateforme de gestion des API, Kong Konnect, afin de créer une couche de connectivité pour l’IA, en commençant par deux fonctionnalités clés : les passerelles d’IA et les serveurs PCM. Les passerelles d’IA permettent aux entreprises d’acheminer, de sécuriser, de surveiller et d’optimiser les appels aux fournisseurs de GML, de PCM et d’API en traitant les points de terminaison pour l’inférence d’IA comme tout autre API, apportant ainsi rapidité, visibilité et contrôles de sécurité à ce qui est actuellement une boîte noire. Parallèlement, le serveur PCM pour Konnect expose le système d’information d’une organisation (API, services, analyse du trafic, etc.) via PCM, ce qui permet à des agents d’IA comme Claude ou Cursor d’interroger Kong Konnect en langage naturel et de récupérer des renseignements exploitables. Ancrée dans sa vision « pas d’IA sans API », la plateforme de Kong est non seulement essentielle à l’infrastructure numérique d’aujourd’hui, mais de plus en plus indispensable pour connecter le nouveau monde agentique.

Prochain chapitre de l’histoire de PCM : la Linux Foundation

En décembre 2025, Anthropic a fait don du protocole de contexte de modèle à la nouvelle Agentic AI Foundation (AAIF), un consortium sous l’égide de la Linux Foundation. L’AAIF a été cofondée par Anthropic, Block et OpenAI, avec l’appui de Google, Microsoft, AWS, Cloudflare et Bloomberg. La fondation a été lancée grâce à trois contributions fondatrices : PCM d’Anthropic, Goose Framework de Block et AGENTS.md d’OpenAI. Le don de PCM par Anthropic garantit que la norme émergente du secteur est gérée dans un environnement neutre, régi par la communauté, plutôt que par une seule entreprise. Cette approche fait écho à la trajectoire de grands projets à source libre tels que Linux, Kubernetes, Node.js et PyTorch, dont l’adoption s’est accélérée après leur passage à une gestion indépendante au sein de la Linux Foundation.

Cette transition reflète également la rapidité avec laquelle la plateforme PCM s’est intégrée à l’écosystème de l’IA, avec plus de 97 millions de téléchargements mensuels de trousses SDK, plus de 10 000 serveurs actifs et des intégrations profondes à l’échelle de Claude, de ChatGPT, de Gemini et de nombreux autres produits d’IA. Sous cette nouvelle direction, MCP servira de norme durable et neutre vis-à-vis des fournisseurs, gérée par un organisme indépendant, réduisant ainsi le risque de dépendance exclusive tout en ouvrant le protocole aux contributions de l’écosystème dans son ensemble. Parallèlement à Goose et AGENTS.md sous l’égide d’AAIF, ces projets définissent la couche de coordination de l’IA agentique, positionnant PCM non plus comme un cadre de développement pratique, mais comme une infrastructure numérique essentielle pour la prochaine génération de flux de travail agentiques.

Une occasion à saisir

En dotant les modèles d’un langage commun et neutre pour accéder aux outils, aux données et aux systèmes, PCM réduit les frictions et permet l’interopérabilité, facilitant ainsi la création de flux de travail agentiques fiables et évolutifs. À mesure que son adoption progressera, nous observerons les mêmes effets écosystémiques que ceux engendrés par les API il y a 20 ans : de nouveaux modèles d’affaires, de nouveaux outils et de toutes nouvelles catégories d’applications construites sur le protocole. La différence cette fois-ci? Les enjeux sont plus élevés, le rythme plus rapide et le potentiel plus important. PCM ne fait pas que connecter des logiciels entre eux, il établit une base qui relie l’IA à tout.

Bien entendu, cette occasion comporte des risques. À titre d’exemple actuel, MCP introduit de nouveaux enjeux de sécurité, allant de la mauvaise utilisation des outils à l’exposition aux données, qui nécessitent des mesures de contrôle et une gouvernance robustes. Construire un écosystème de façon responsable implique de trouver l’équilibre entre ouverture et protection, tout comme les API ont évolué pour inclure des normes d’authentification, des limitations de requêtes et de la surveillance.

L’histoire de PCM est encore en cours de rédaction, mais la leçon tirée des API est claire : une norme à elle seule ne change pas le monde. Les normes créent des écosystèmes, et les écosystèmes transforment les secteurs d’activité. En cas de succès, PCM comptera moins comme innovation de produits que comme changement infrastructurel, c’est-à-dire qu’il changera la façon dont l’IA est conditionnée, partagée et déployée à grande échelle dans le paysage technologique pour les décennies à venir.